Forskere ved MIT lanserer en dristig idé: Ulike AI-modeller kan være på vei mot en felles måte å representere virkeligheten på. Hypotesen, ledet av Phillip Isola, har utløst intens debatt og ny forskning. Konklusjonen er ikke avgjort — men sporene peker mot konvergens.

Hypotesen: Et felles språk for verden

Den såkalte Platonic Representation Hypothesis hevder at språkmodeller, synsmodeller og andre AI-systemer utvikler lignende interne representasjoner av verden, selv når de trenes på ulike data og med ulike metoder.

Navnet henter fra Platons huleallegori: Som fanger som ser skygger på veggen, har AI-modeller bare tilgang til datastrømmer — ikke selve virkeligheten. Likevel ser modellene ut til å samstemme i hvordan de strukturerer det de «ser».

«Hvorfor stemmer språkmodellen og synsmodellen overens? Fordi de begge er skygger av samme verden», forklarer Isola ifølge Quanta Magazine.

Platons huleallegori: Mennesker ser bare skygger av virkeligheten.

Platonic Representation Hypothesis: AI-modeller lærer like representasjoner fordi de tolker den samme verden gjennom ulike data.

Hva forskningen viser

Studiene peker på flere former for konvergens:

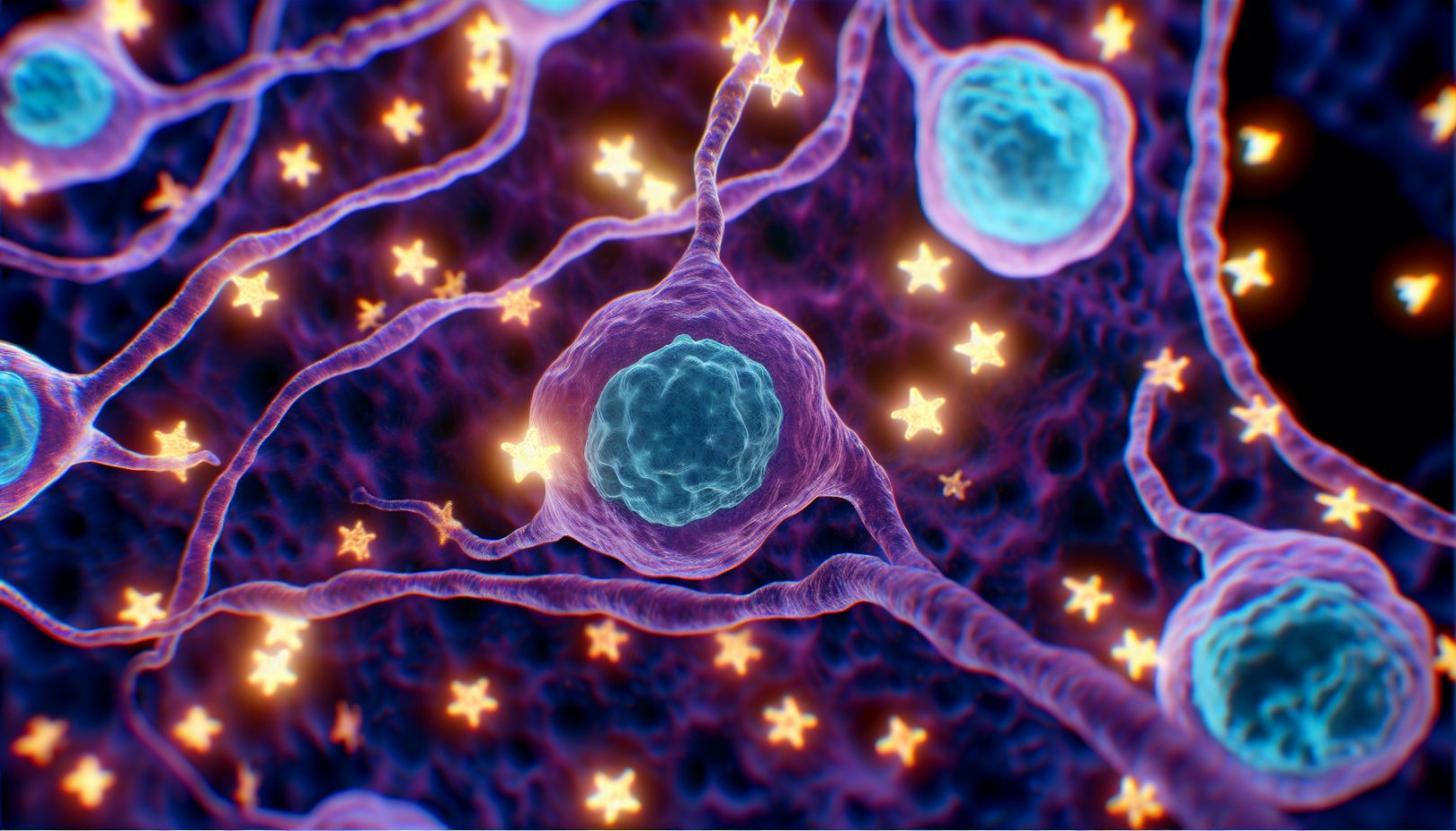

- På tvers av datatyper: Når syns- og språkmodeller blir større og mer kapable, måler de avstanden mellom datapunkter på stadig mer like måter. En kraftig språkmodells representasjon av ordet «hund» kan ligne en synsmodells representasjon av hundebilder, selv uten identisk trening.

- Over tid og domener: Ulike nevrale nettverk — med forskjellige arkitekturer og treningsdatasett — beveger seg mot lignende representasjoner etter hvert som de blir mer kapable.

Kontrovers og kritikk

Hypotesen begeistrer og provoserer i fagmiljøene. Et hovedspørsmål er hvilke representasjoner man undersøker, og hvor i nettverkene man leter.

- Man kan ikke granske alle mulige setninger i en språkmodell eller alle bilder i en synsmodell.

- Valg av hvilke noder og lag i nettverket man undersøker, påvirker funnene.

- Sammenligning på tvers av svært ulike modeller er metodisk krevende.

«Halvparten av forskningsmiljøet sier dette er åpenbart, og den andre halvparten sier dette åpenbart er feil», sier Isola. «Vi var fornøyde med den responsen».

Hvorfor dette kan bety mye

Hvis hypotesen stemmer, kan det finnes en optimal måte å kode kunnskap om verden på — en «magnet» som trekker ulike modeller mot samme struktur.

- Det kan forklare hvorfor transfer learning fungerer så godt i praksis.

- Det reiser filosofiske spørsmål: Beveger AI seg mot en objektiv forståelse av verden, eller skyldes konvergensen overlappende treningsdata og like arkitekturmønstre?

Feltet er fortsatt ungt, og debatten er langt fra avgjort. Like fullt har hypotesen allerede stimulert ny forskning og presset AI-forskere til å tenke dypere over hva modellene egentlig lærer.

Konklusjon: MIT-forskernes platonske hypotese setter ord på et mønster mange har observert: Ulike AI-modeller kan være i ferd med å lære samme underliggende struktur av verden. Om dette er et skritt mot objektiv forståelse, eller et resultat av like treningsløp og arkitekturer, blir nå testet videre i laboratorier og på arXiv.

Kilder: Quanta Magazine, MIT (The Platonic Representation Hypothesis), arXiv

Kommentarer

0 kommentarer

Vi godtar kun kommentarer fra registrerte brukere. Dette gjør vi for å opprettholde en trygg og respektfull debatt, samt for å unngå spam og misbruk. Registrering er gratis og tar bare noen sekunder.

Du må være innlogget for å kommentere. Logg inn eller registrer deg for å delta i diskusjonen.